Jak (rzetelnie) mierzyć skuteczność chatbotów?

Za chatbotami szły duże obietnice. Miały odciążyć przeładowane biura obsługi klienta i zapewnić szybszą obsługę. Jednak pomimo dużych nadziei, wiele chatbotów częściej frustruje, niż pomaga i jest problem z poprawną oceną ich skuteczności.

W tym artykule opiszemy jakie błędy popełnia się przy ocenie skuteczności chatbotów i jaką metodę oceny wypracowaliśmy w PerfectBot na podstawie doświadczeń z automatyzacji 9 milionów rozmów dla największych firm z branży Ecommerce.

Skąd bierze się problem niepoprawnego mierzenia skuteczności chatbotów?

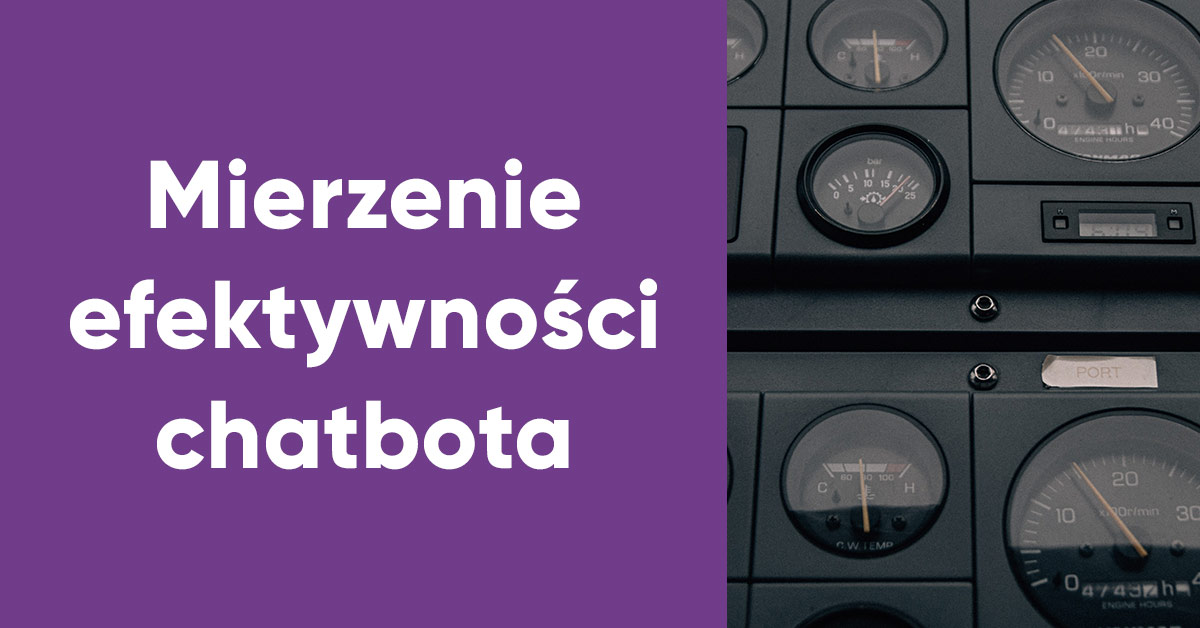

O skali tego problemu świadczą wyniki „Raportu Grupy K2: Technologie i marketing w e-commerce – wyzwania i trendy 2021” na podstawie badania, zrealizowanego przez IDG Poland wśród 252 osób decyzyjnych z branży e-commerce w Polsce. Okazuje się, że 39 proc. e-sklepów wcale nie mierzy skuteczności bota. A ponad połowa wie jedynie, ile spraw podjął samodzielnie, bez przekazania rozmowy do konsultanta. Nie ma przy tym wiedzy, ile z nich obsłużył prawidłowo.

Jeżeli branża e-commerce, znana z bardzo dokładnego mierzenia biznesu i stosowania zaawansowanej analityki, nie zna skuteczności swoich chatbotów, to można podejrzewać, że w innych branżach nie jest lepiej.

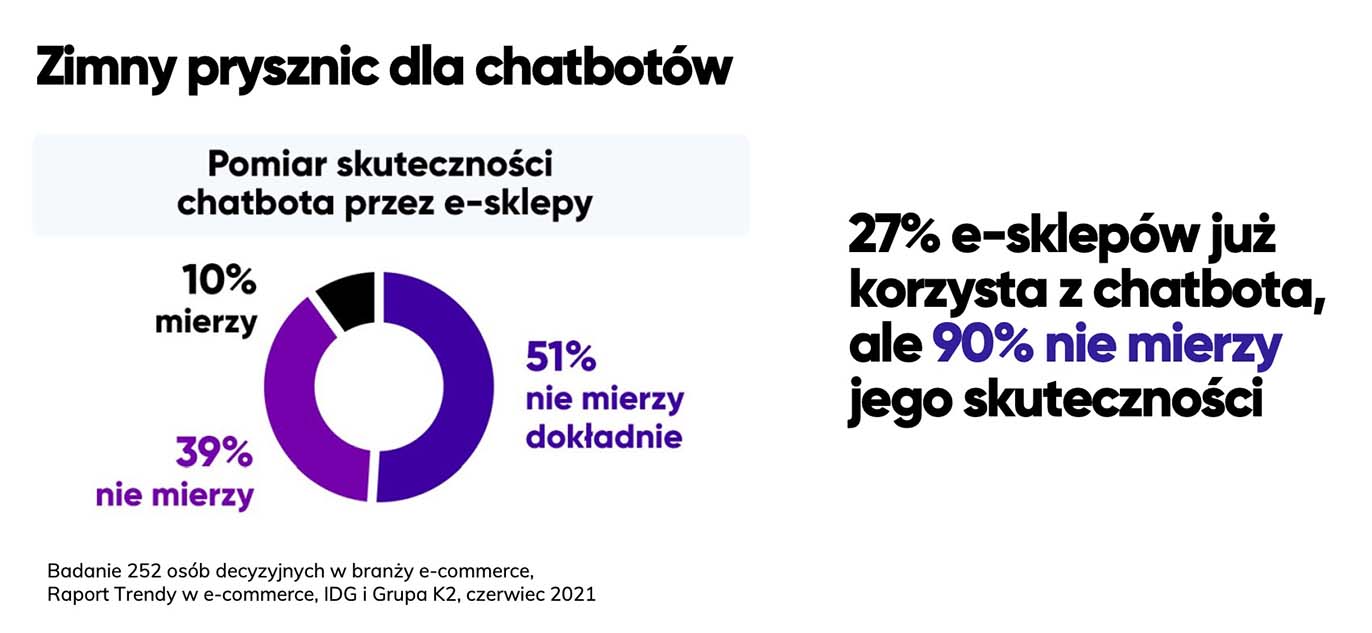

Opisywana metoda pomiaru skuteczności opiera się na ocenie skuteczności botów konwersacyjnych, czyli takich, które starają się odpowiadać na pytania zadane językiem naturalnym.

W przypadku tzw. chatbotów regułkowych nie oceniamy skuteczności odpowiadania na pytania, tylko przejścia przez proces. Ocena nie jest zatem wyzwaniem. Skoro taki chatbot nie odpowiada na pytania otwarte, tylko działa w praktyce jak formularz z zamkniętymi możliwościami wyboru, to jego skuteczność powinna wynosić 100 proc (tak jak każdego innego formularza na stronie).

Boty regułkowe obsługują jedynie konkretne procesy (np. sprawdzenie statusu reklamacji) i ich wpływ na odciążenie obsługi klienta jest ograniczony.

Klienci chcą zadawać pytania po swojemu, dlatego dążą do kontaktu z BOK. I dlatego tylko chatbot konwersacyjny, który stara się zrozumieć język naturalny, jest w stanie obsłużyć szeroki zakres spraw. Na ocenie tych botów się skupimy.

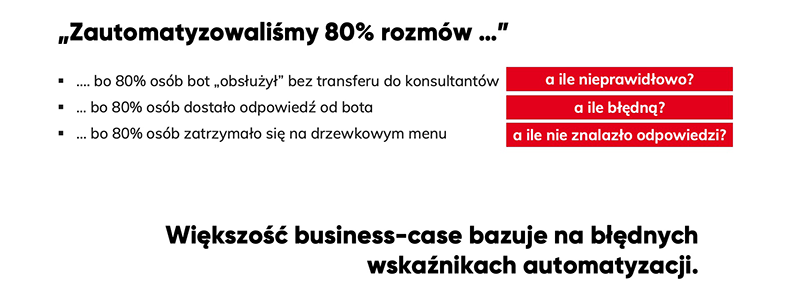

Błąd #1 – Nie należy uznawać, że każda rozmowa zakończona w chatbocie to rozmowa poprawnie zautomatyzowana.

Pierwszym błędem popełnianym nawet przez globalnych dostawców chatbotów jest założenie, że jeżeli bot nie przełączył rozmowy do konsultanta, to została ona zautomatyzowana – w domyśle prawidłowo obsłużona.

Taka rozmowa została co najwyżej „powstrzymana”, tym samym nie powinna wliczać się do wskaźnika „automatyzacji”, tylko do „wskaźnika powstrzymania” (containment rate), znanego z oceny systemów IVR infolinii telefonicznej. Wskaźnik powstrzymania niewiele mówi o skuteczności chatbota.

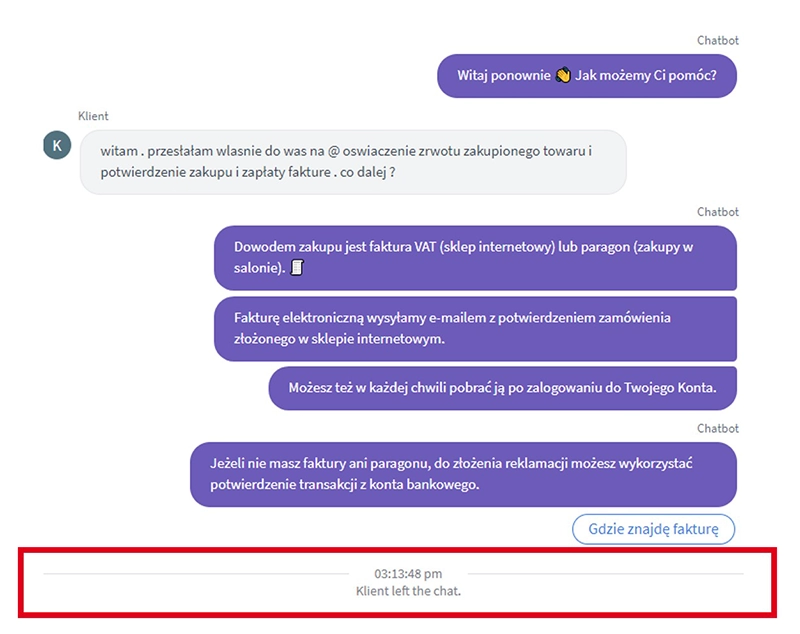

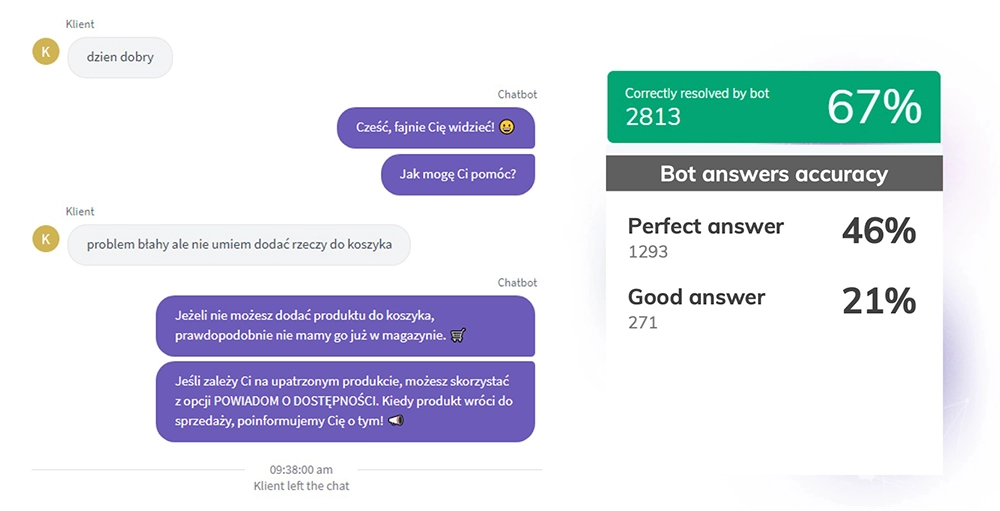

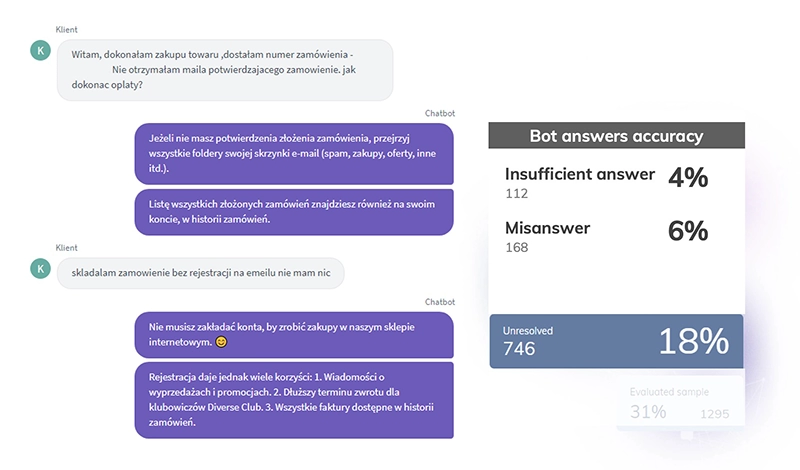

W przypadku tekstowego bota konwersacyjnego brak eskalacji do konsultanta nie oznacza bowiem prawidłowej obsługi. Pokazuje to przykładowa rozmowa poniżej.

Klient otrzymał złą odpowiedź i bez słowa opuścił konwersację. To częsty problem. Mamy tu do czynienia z tzw. odpowiedzią „false positive”, czyli chatbot źle rozpoznał pytanie i udzielił błędnej odpowiedzi. Dopiero człowiek po przeczytaniu rozmowy może ją miarodajnie ocenić, bo według bota ta rozmowa została przeprowadzona prawidłowo – skoro udzielił odpowiedzi i nie doszło do eskalacji.

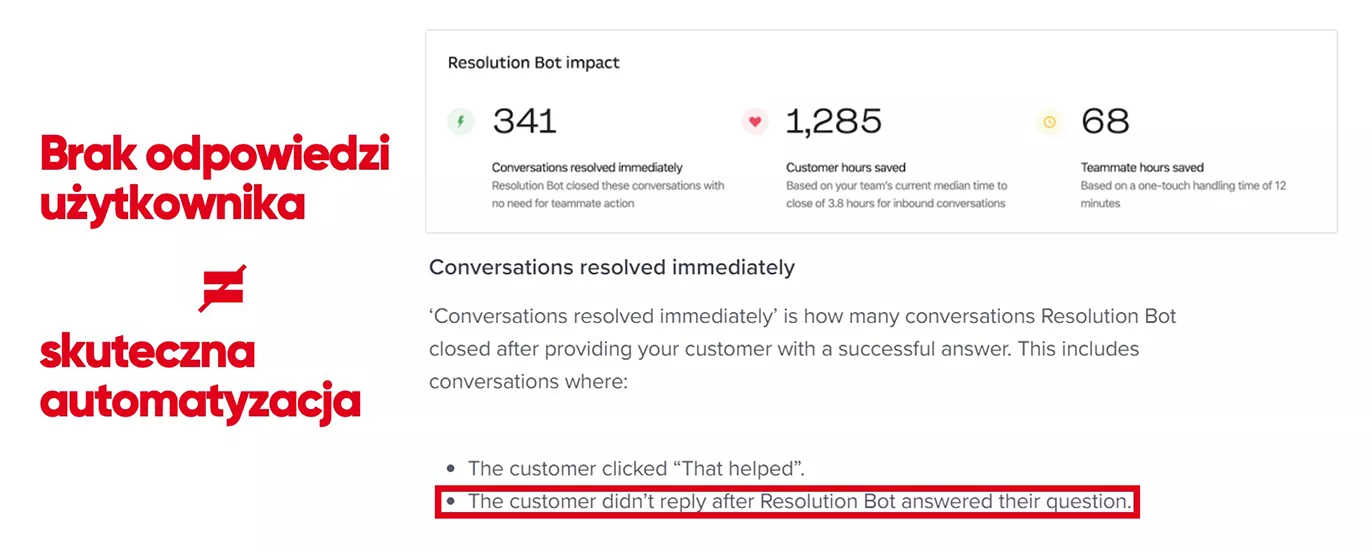

Błąd #2 – Brak reakcji użytkownika po odpowiedzi chatbota nie oznacza rozmowy poprawnie zautomatyzowanej.

To naciągane założenie stosują do oceny skuteczności chatbotów nawet globalni potentaci. Poniżej widać, jak Intercom – jeden z czołowych graczy wdrażających narzędzia do chatu i automatyzacji obsługi klienta na chacie – uznaje za rozmowy poprawnie zautomatyzowane wszystkie, w których klient nic nie odpowiedział po uzyskaniu odpowiedzi przez bota.

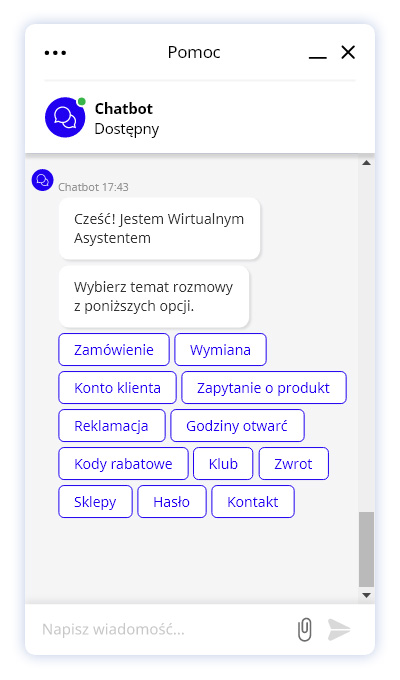

Błąd #3 – To, że użytkownik „poklikał” po menu bota, nie oznacza, że uzyskał odpowiedź.

Ostatni błąd oceny popełniany jest w przypadku botów, które promują wybór odpowiedzi z listy startowej, zamiast udzielania konkretnych odpowiedzi na otwarte pytania.

Jeżeli użytkownik nie zada pytania swoimi słowami, tylko poklika po startowym menu, to nie wiemy, z jakim problemem tak naprawdę przyszedł – i tym samym czy mu pomogliśmy.

Wśród takich „klikanych rozmów” znajdują się zautomatyzowane, ale nie można uznawać, że wszystkie z nich takie są. Osoba, która nie znalazła odpowiedzi w menu bota, chwilę później może dzwonić na infolinię lub wysłać maila.

Wskaźnik automatyzacji jest podstawą do oszacowania efektów biznesowych z wdrożenia chatbota np. uzyskanych oszczędności. Jeżeli opiera się na błędnych założeniach, to wypacza wszystkie późniejsze wyliczenia korzyści biznesowych.

Dlatego analizując business-case powinniśmy zawsze zadać pytanie – jak konkretnie został policzony wskaźnik automatyzacji.

Nasze chatboty obsłużyły do tej pory 5 milionów rozmów dla największych firm Retail & Ecommerce. Z tych rozmów przeczytaliśmy i ręcznie oceniliśmy kilkadziesiąt tysięcy. To pozwoliło nam wypracować następującą metodę oceny skuteczności botów.

#1 – Ocena chatbota powinna być częściowo manualna.

Bazowanie jedynie na wskaźnikach uzyskanych automatycznie (np. procent eskalacji czy rozpoznanych pytań) – jest niewystarczające. Miarodajna ocena wymaga udziału człowieka, który czyta i ocenia statystycznie istotną próbkę rozmów. Dlatego w okresie optymalizacji każdego nowo wdrożonego PerfectBota czytamy i oceniamy nawet do 50 proc. rozmów.

#2 – Ocena chatbota powinna być transparentna.

Ocena powinna być łatwa do sprawdzenia. Dlatego w PerfectBot każda oceniona przez eksperta rozmowa jest otagowana w archiwum rozmów. Klient nie tylko dostaje zagregowany wynik skuteczności, ale może zweryfikować każda pojedynczą ocenę. To buduje zaufanie do wyników.

#3 – Ocena chatbota powinna dotyczyć końcowego efektu rozmowy.

Należy oceniać końcowy efekt rozmowy, a nie to czy bot trafił z pojedynczą odpowiedzią w rozmowie.

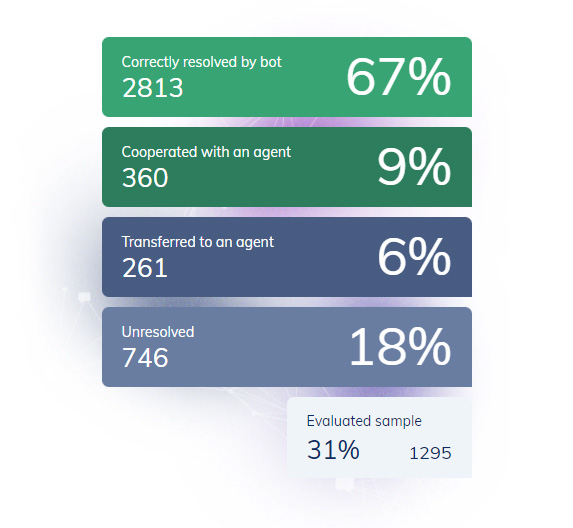

W PerfectBot klasyfikujemy rozmowy do 4 głównych grup.

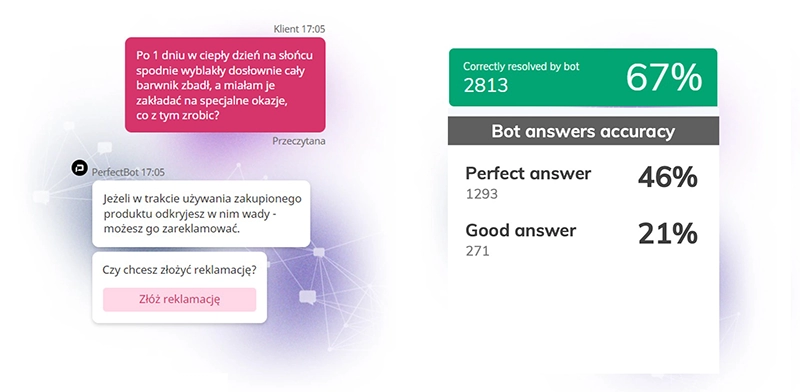

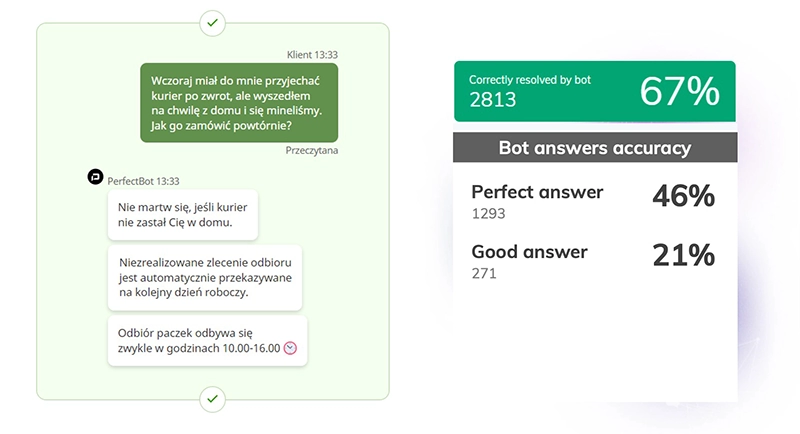

Prawidłowe rozwiązanie przez bota – odpowiedź perfekcyjna

Chatbot doskonale zrozumiał, czego potrzebowała użytkownik, i to pomimo tego, że problem został opisany w zniuansowany sposób.

Prawidłowe rozwiązanie przez bota – odpowiedź wystarczająco dobra

Można przypuszczać, że bot rozwiązał sprawę poprawnie, choć z uwagi na brak informacji zwrotnej nie ma takiej pewności.

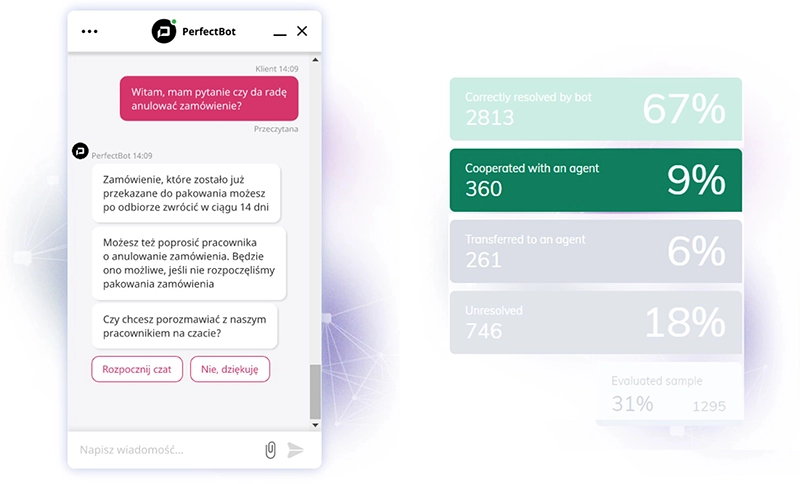

Rozwiązanie we współpracy z agentem

Chatbot poprawnie rozpoznał pytanie, udzielił częściowej odpowiedzi, która może być wystarczająca. Jednocześnie zaoferował użytkownikowi możliwość kontaktu z konsultantem.

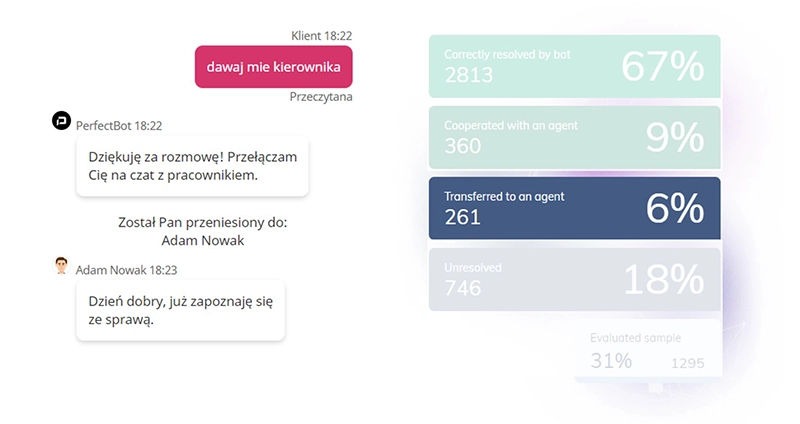

Przełączenie do agenta

Użytkownik poprosił o przełączenie do konsultanta po udzieleniu wcześniej złej odpowiedzi przez bota.

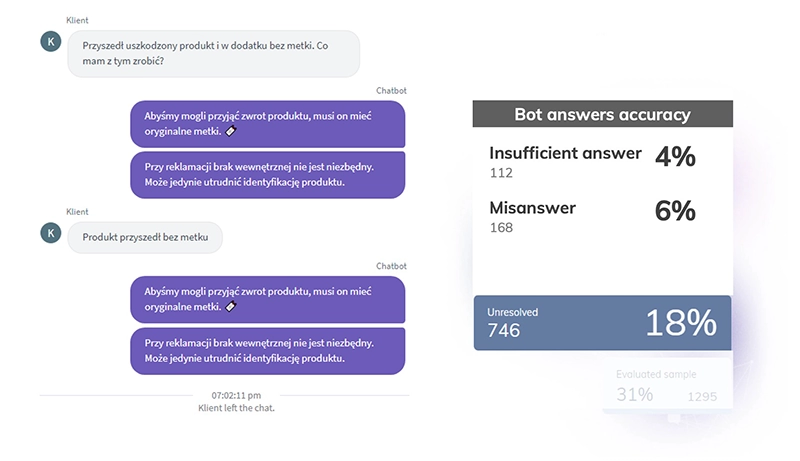

Problem nierozwiązany – odpowiedź niewystarczająca

Na pierwsze pytanie użytkownika bot nie odpowiedział konkretnie, przez co nie został zrozumiany. Powtórzył odpowiedź, użytkownik zrezygnował, prawdopodobnie niezadowolony z niewystarczającej odpowiedzi.

Problem nierozwiązany – odpowiedź nieprawidłowa

Aby rzetelnie mierzyć skuteczność chatbota, należy:

Prawda może być trudna dla wielu chatbotów, ale wymusi ich rozwój. Zachęcamy do przeprowadzania rzetelnej oceny skuteczności chatbotów, bo to pierwszy krok do tego, aby boty zamiast frustrować, stały się istotnym odciążeniem obsługi klienta.

Prelekcja Łukasza Lewandowskiego (ceo PerfectBot) na Customer Care Festival 2021.

39 proc. e-sklepów wcale nie mierzy skuteczności bota. Niewiele ponad połowa (51 proc.) wie jedynie, ile spraw podjął samodzielnie, bez przekazania rozmowy do konsultanta.

Przeczytaj

PerfectBot od K2Bots pomaga dostosować obsługę klienta do gwałtownego wzrostu sprzedaży online. Prawidłowo obsługuje 200 najczęstszych problemów klientów.

Przeczytaj

Chatbot dedykowany

do Retail & Ecommerce

Najwyższa na rynku

efektywność

Gotowy nawet

w 2 tygodnie

Language: PL | EN